В 2024 году сотрудник финансового отдела международной компании в Гонконге перевёл мошенникам 25 миллионов долларов после видеоконференции с «финансовым директором», созданным с помощью технологии дипфейк.

Многим слово дипфейк уже знакомо, для других — это относительно новое понятие. Но мошенники уже давно умело пользуются возросшей доступностью инструментов искусственного интеллекта в преступных целях.

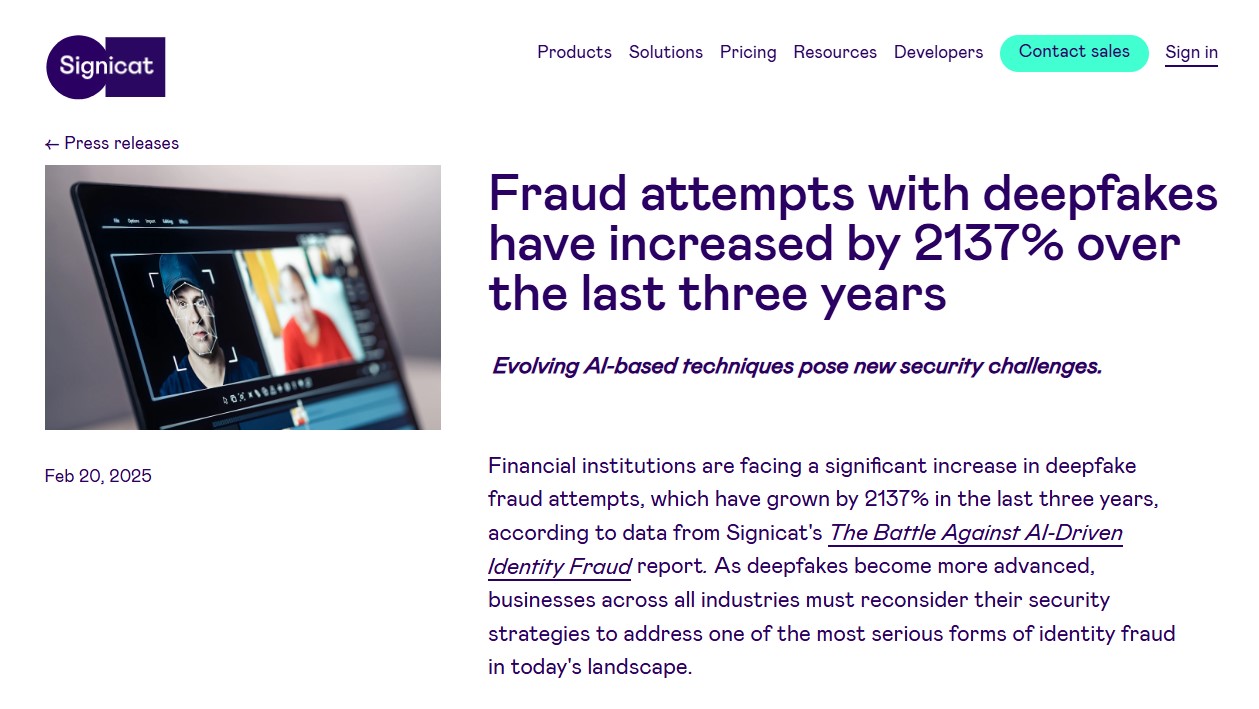

Согласно отчёту компании Signicat о мошенничестве с использованием ИИ для кражи личных данных, опубликованному в 2025 году, число попыток мошенничества с применением дипфейков в финансовом секторе выросло на 2137% за последние три года. Сегодня 42,5% попыток мошенничества в секторе связаны с использованием ИИ.

Редакция Factcheck.kz рассказывает, как мошенники используют дипфейки, и как их распознать.

Как мошенники используют дипфейки

Злоумышленники используют технологию дипфейк на основе искусственного интеллекта для создания реалистичных поддельных видео, аудио или изображений, имитирующих других людей: это могут быть известные люди или даже члены семьи.

Создавая иллюзию реальности в звонках, видеозвонках, сообщениях или рекламах, мошенники, буквально прикрываясь образом другой персоны, пытаются обманом выманить у своих жертв деньги или персональные данные.

Обычно чем больше изображений человека есть у нейросети, на которых можно обучиться, тем правдоподобнее получится дипфейк. Однако искусственный интеллект становится всё более эффективным, и сегодня может справиться с задачей и с малым объёмом данных. Мошенникам может быть достаточно короткого видео, опубликованного в социальных сетях. Результат не обязательно будет качественным, но, к сожалению, во многих случаях грубо сделанного дипфейка достаточно, чтобы обмануть пользователя.

Технически важно отличать дипфейк от полностью сгенерированного ИИ видео. В случае дипфейка изображение человека накладывается на исходное, реальное видео. Порой оригинальное видео просто изменяется с помощью нейросети. Это самый простой способ, при котором синтезу подвергается лишь речь и движение губ. Такое достаточно часто встречается в мошеннических рекламах онлайн с изображением публичных лиц.

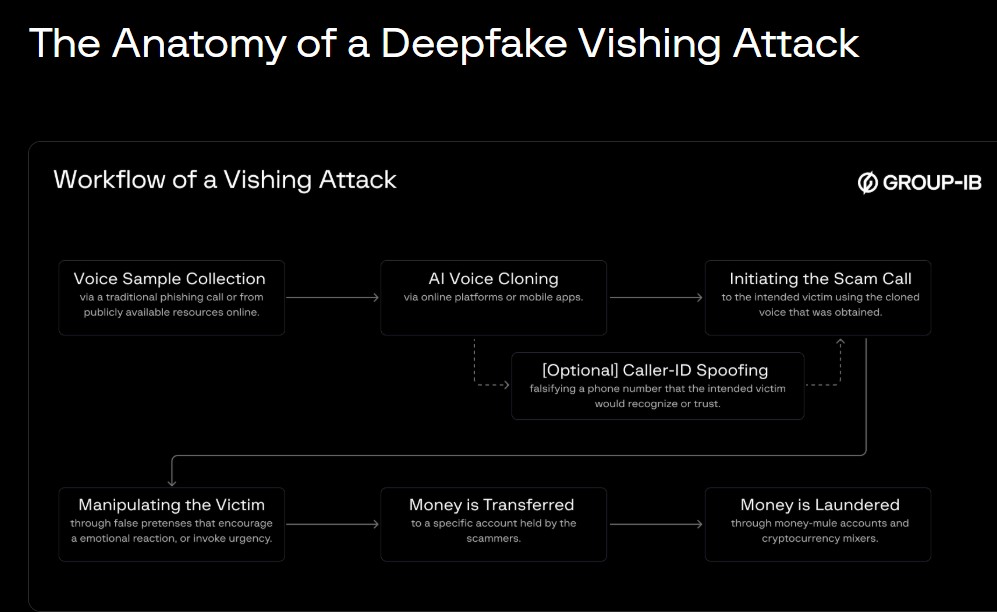

Гораздо дальше продвинулась технология клонирования голоса. Используя образцы голоса, например из аудиозаписей человека, мошенники с помощью ИИ могут имитировать того, кого жертва знает и кому доверяет, например члена семьи или коллегу.

Другими источниками образцов голоса могут быть социальные сети, вебинары, онлайн-встречи и даже телефонные разговоры. Мошенникам может быть достаточно записать короткое: «Алло, здравствуйте! Кто это?», чтобы затем клонировать голос.

Существует два основных метода использования клонированных голосов при фишинговых атаках: 1) заранее подготовленное аудио: используется клонированный голос на основе заранее написанного сценария; 2) преобразование слов мошенника «в голос знакомого человека» в режиме реального времени.

Например, вам звонит «мама» или «ребёнок» и срочно просит денег. Точно так же в финансовый отдел может «позвонить генеральный директор» и дать указание срочно авторизовать банковский перевод для крайне важной деловой транзакции.

Что делать

О том, как распознать дипфейки, циркулирующие онлайн, мы писали в ряде наших материалов (1, 2, 3, 4, 5). Ниже — представляем небольшую инструкцию.

Видео

Первым всегда идёт визуальный анализ.

♦ Обращаем внимание на лицо и мимику: движутся ли губы в соответствии с речью, совпадают ли мимика и жестикуляция рук с темой разговора, нет ли редкого или неестественного моргания глаз, искажений в области рта (язык, зубы)?

♦ Границы лица: нет ли размытия краев, искажений ушей, шеи или аксессуаров (вроде очков), особенно при движении головы?

♦ Свет и тени: нет ли разницы в освещении лица и фона, естественно ли выглядят блики на стёклах, правильно ли падают тени, следуют ли они движениям?

♦ Контекст: имеет ли смысл происходящее?

Затем следует технический анализ с помощью автоматизированных сервисов.

♦ Для начала имеет смысл провести обратный поиск по кадру из видео, чтобы посмотреть, не создан ли дипфейк на основе существующего в интернете ролика.

♦ Затем можно использовать доступные инструменты детекции, например Deepware, AIorNOT, Hive, Deepfake-o-meter. Важно помнить, что они выдают результат в процентах вероятности, а не окончательный вердикт. Поэтому выводы нужно интерпретировать осторожно, особенно если они спорные (допустим, 50%).

♦ Контекст: кто и когда опубликовал видео (источник), заслуживает ли он доверия? Каким может быть мотив, кто первоисточник? «Прогуглите» информацию из видео, чтобы проверить её на достоверность.

Аудио

Первым идёт аудиальный анализ, то есть прослушивание. Что должно вызвать подозрение:

♦ неестественный темп без нормальных колебаний или дыхания;

♦ безупречное произношение, лишённое несовершенств естественной речи;

♦ роботизированная ритмика, неправильные ударения;

♦ отсутствие фонового шума или же его статичность;

♦ фразы или термины, которые человек никогда бы на самом деле не использовал.

Затем переходим к техническому анализу.

♦ Сравните темп и манеру речи с эталоном, то есть с реальным голосом того человека, чей голос якобы звучит в аудио.

♦ Используйте инструменты детекции, например: Deepfake-o-meter, Hive, AIorNOT, Hiya Deepfake Voice Detector. Помните, что они выдают результат в процентах вероятности.

♦ Проверьте источник записи, поищите озвучиваемую информацию в интернете.

Советы, приведённые выше, хорошо работают при проверке контента, циркулирующего онлайн, когда у пользователя есть время разобраться. Однако иногда мошенники могут застать человека врасплох, например, позвонив по аудио- или видеосвязи и имитируя знакомого или сотрудника банка или полиции. Инструкцию для таких случаев мы расписывали в нашем материале о том, как противостоять телефонным мошенникам.

Ключевой принцип: внимательность. Не торопитесь принимать финансовое решение, не изучив подробно как саму информацию, так и её источник. Будьте начеку. Только так можно избежать обмана.