Generativ süni intellekt texnologiyasının sürətli inkişafı sintetik medianı insan hissləri ilə ayırd etməyi çox çətinləşdirib.

Belə çıxır ki, hətta ailə üzvlərimiz də bizi tanımır! Bunun son nümunəsi müğənni Keti Perrinin başına gəlib. Mayın 6-da “Met Gala” keçirilən zaman bir çox internet istifadəçisi Perrinin çiçəklərlə bəzədilmiş libasındakı pozalarını heyranlıqla şərh edib.

Görünür, Keti Perrinin üzü süni intellekt alətləri ilə hazırlanan görüntüyə sonradan əlavə edilib. Perri proqramların çoxluğuna görə bu tədbirə qatılmayıb. O, açıqlama verərək şəklin real olmadığını izah edib. Amma məsələ ondadır ki, məşhur sənətçinin anasının fotoların real olduğunu düşünərək qızına tərif dolu sözlərlə göndərdiyi mesaj sosial şəbəkədə paylaşılıb.

İnsan gözünü asanlıqla aldada biləcək görüntülər hazırlanarkən, bir çox istifadəçi süni intellektin yaratdığı məhsulları aşkar etmək üçün məhz süni intellektdən texnikalarından istifadə edilir. Lakin bu vasitələrin nəticələrinə tam etibar etmək bir az çətindir. Çünki eyni görüntü üçün müxtəlif aşkarlama vasitələrindən fərqli cavablar ala bilərsiniz.

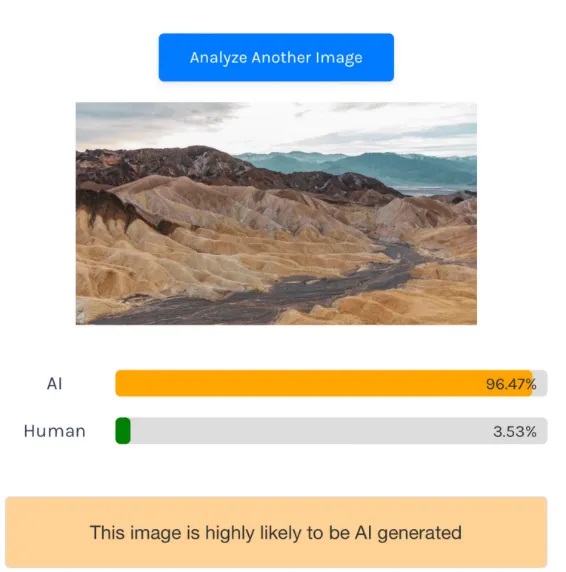

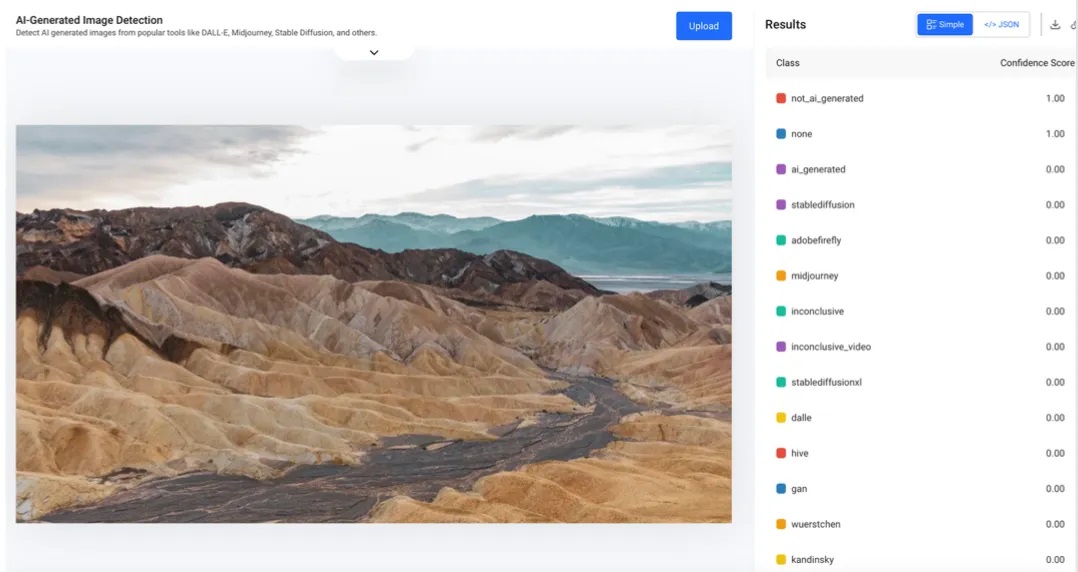

Məsələn, Kaliforniyada çəkilmiş bu foto üçün 3 fərqli alətdən 3 fərqli nəticə əldə edilib: “isitait” adlı alət görüntünün süni intellekt tərəfindən hazırlandığı nəticəsinə gəlib.

“Aiornot” bildirib ki, görüntü çox güman ki, insan tərəfindən çəkilib.

“Hive Moderation” isə görüntünün əsl fotoşəkil olduğu qənaətinə gəlib. Belə olan halda, süni intellektin aşkarlama vasitələrinə etibar edə bilərikmi?

Bunu başa düşmək üçün əvvəlcə bu vasitələrin necə işlədiyinə baxaq.

AI aşkarlama vasitələri necə işləyir?

Süni intellekt detektorları, süni intellektin şəkil, video və ya mətnin istehsal prosesində iştirak edib-etmədiyini real vaxt rejimində emal edən və yoxlayan vasitələri müəyyən etmək üçün istifadə olunur.

Bu alətləri inkişaf etdirərkən, adətən həm orijinal, həm də süni intellekt tərəfindən yaradılan mətn və şəkilləri ehtiva edən bir sıra təlim məlumatları verilir. Bu məlumatların işlənməsi zamanı süni intellektin yaratdığı şəkillər və mətnlərdəki ortaq xüsusiyyətlər müəyyən edilir. Beləliklə, aşkarlama vasitələri bu ümumi xüsusiyyətlərə əsaslanaraq bir məzmunun süni intellektin köməyi ilə istehsal edilib-edilmədiyinə qərar verir.

Ancaq süni intellekt aşkarlama vasitələrinin verdiyi nəticələr ehtimallara əsaslandığı üçün hələlik 100 faizlik həqiqəti təmin etmək mümkün görünmür.

Digər mühüm məqam isə süni intellekt texnologiyası kimi aşkarlama vasitələrinin də günbəgün inkişaf etməsidir. Yəni istifadə etdiyimiz modellərin nəticələri bu gün bizi qane etməsə də, sabah mükəmməl ola bilər. Buna görə də aşkarlama vasitələrinin elan etdiyi yeniləmələri və təkmilləşdirmələri izləmək, onların fəaliyyətini qiymətləndirmək üçün daha obyektiv perspektiv təmin edə bilər .

Süni intellekt aşkarlama vasitələrinin təqdim etdiyi nəticələrin əksəriyyəti ya ehtimal diapazonu verir (məsələn, 85 faiz insan), bəziləri isə yalnız ikili “bəli/yox” qənaətinə gəlir.

Aşkarlama modeli, məsələn, aşkar etmək üçün nə öyrədildiyi, sonuncu dəfə nə vaxt yeniləndiyi kimi daha çox məlumat olmasa, onun nəticələrini şərh etmək çətindir .

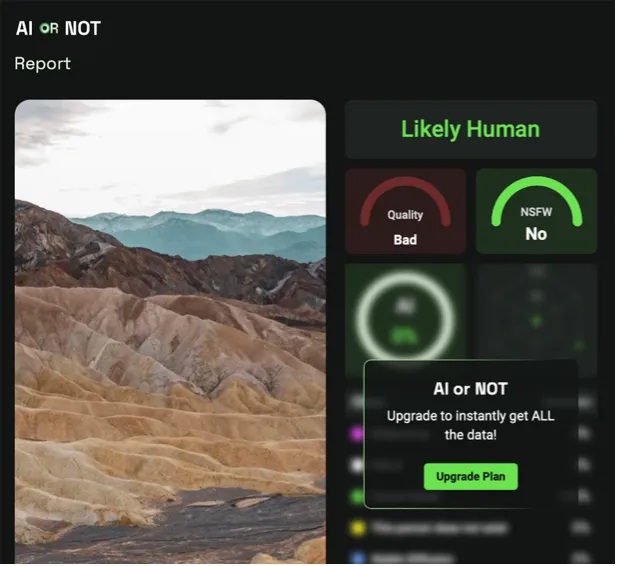

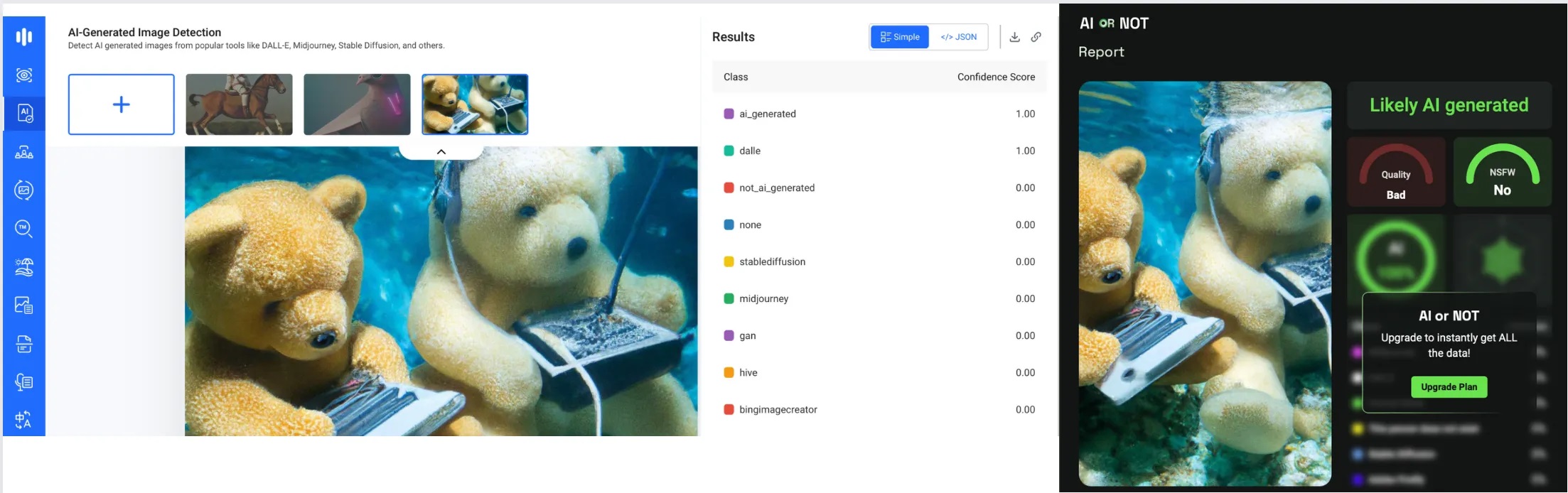

Məsələn, “Hive Moderation”da təsvirin süni intellekt tərəfindən hazırlanacağını göstərən bəzi etiketlər var. Bununla belə, nəticə sıralamasındakı 1 və 0 dəyərləri istifadəçilər üçün çox da anlaşılan olmaya bilər. Eyni şəkil AI və ya “Not” alətinə yükləndikdə, nəticə "ehtimal ki, süni intellekt tərəfindən istehsal edilmişdir" xəbərdarlığı ilə görünür.

Soldakı nəticə “Hive Moderation”, sağdakı nəticə isə AI və ya “Not” üçündür.

Bəs bu nəticələri qəti sübut kimi istifadə etmək nə dərəcədə düzgündür? Bu alətlər nə dərəcədə etibarlıdır? Onların fəaliyyətinə nə təsir edir?

İnsan mərkəzli texnologiya müdafiəçisi “Witness”in pulsuz və ya ucuz qiymətə əldə edilə bilən aşkarlama vasitələrinin performansını qiymətləndirən fevral araşdırması bu mövzuda mühüm tapıntılar təqdim edir. Tez-tez istifadə edilən aşkarlama vasitələrinin öyrənildiyi araşdırmada “Optic”, “Hive Moderation”, V7, “Invid”, “Deepware Scanner”, “Illuminarty”, “DeepID” kimi vasitələrin mövcud məhdudiyyətləri və alətlərdən istifadəyə qərar verilərkən hansı amillərin nəzərə alınması lazım olduğu vurğulanır.

Mütəxəssislərin fikrincə, alətin dəqiq və ardıcıl nəticələr verib-verməməsi istifadə olunan təlim məlumatlarının keyfiyyətindən, kəmiyyətindən və növündən, həmçinin onun tərtib olunduğu alqoritmik funksiyalardan asılıdır. Məsələn, aşkarlama modeli aləti süni intellekt tərəfindən yaradılmış şəkilləri aşkarlaya bilsə də, dərin saxta videolarda istənilən nəticəni verməyə bilər.

Bəs bu alətlər nəyi aşkar etməkdə çətinlik çəkir? Başqa sözlə, bu alətləri aldatmaq olarmı?

Araşdırma komandası deyir ki, əgər süni intellekt tərəfindən yaradılan məzmun sonradan manipulyasiya edilirsə, süni intellektin aşkarlama vasitələri bunu müəyyən edə bilməz. Məsələn, 2023-cü ilin mayında Pentaqonda partlayışı əks etdirən bir görüntü yayıldı. Görüntü tez bir zamanda təkzib edilsə də, xəbər mərkəzlərində bu hadisə fakt kimi təqdim edilib.

Görünüşün süni intellekt tərəfindən yaradıldığını müəyyən etmək mümkün olsa da, şəklin sağ tərəfi kəsildikdə, analiz ekranında təsvirin real olduğuna dair fərqli bir nəticə ortaya çıxdı.

Bənzər bir vəziyyət Barak Obamanın dərin saxta videosu ilə də baş verdi. Ekran baxışı aşağı salındıqda və videonun bir hissəsi çıxarıldıqda, aşkarlama alətlərinin nəticəsi dəyişdi. Skrinşot çəkmək də ayırdetmə qabiliyyətini azaltdığından, aşkarlama vasitələri üçün süni intellektin yaratdığı şəkilləri aşkar etmək çətinləşib. Buna görə də, yoxlamadan əvvəl, mümkünsə, şəkil və ya videonun ilk dərc edilmiş versiyasını tapmaq faydalıdır.

Bəzi aşkarlama vasitələrinin hazırlanmasında yalnız siyasətçilərdən və məşhur adlardan istifadə edildiyi məlumdur. Bu alətlər az tanınan insanların süni intellekt təsvirlərini aşkar etməkdə daha az müvəffəqiyyətlidir. Üstəlik, məşq vaxtı videoların araşdırılması zamanı daha aydın səsli videolardan istifadə olunubsa, səslərin üst-üstə düşdüyü və ya fon səs-küyü olan videolarda dəqiq nəticə əldə etmək mümkün deyil.

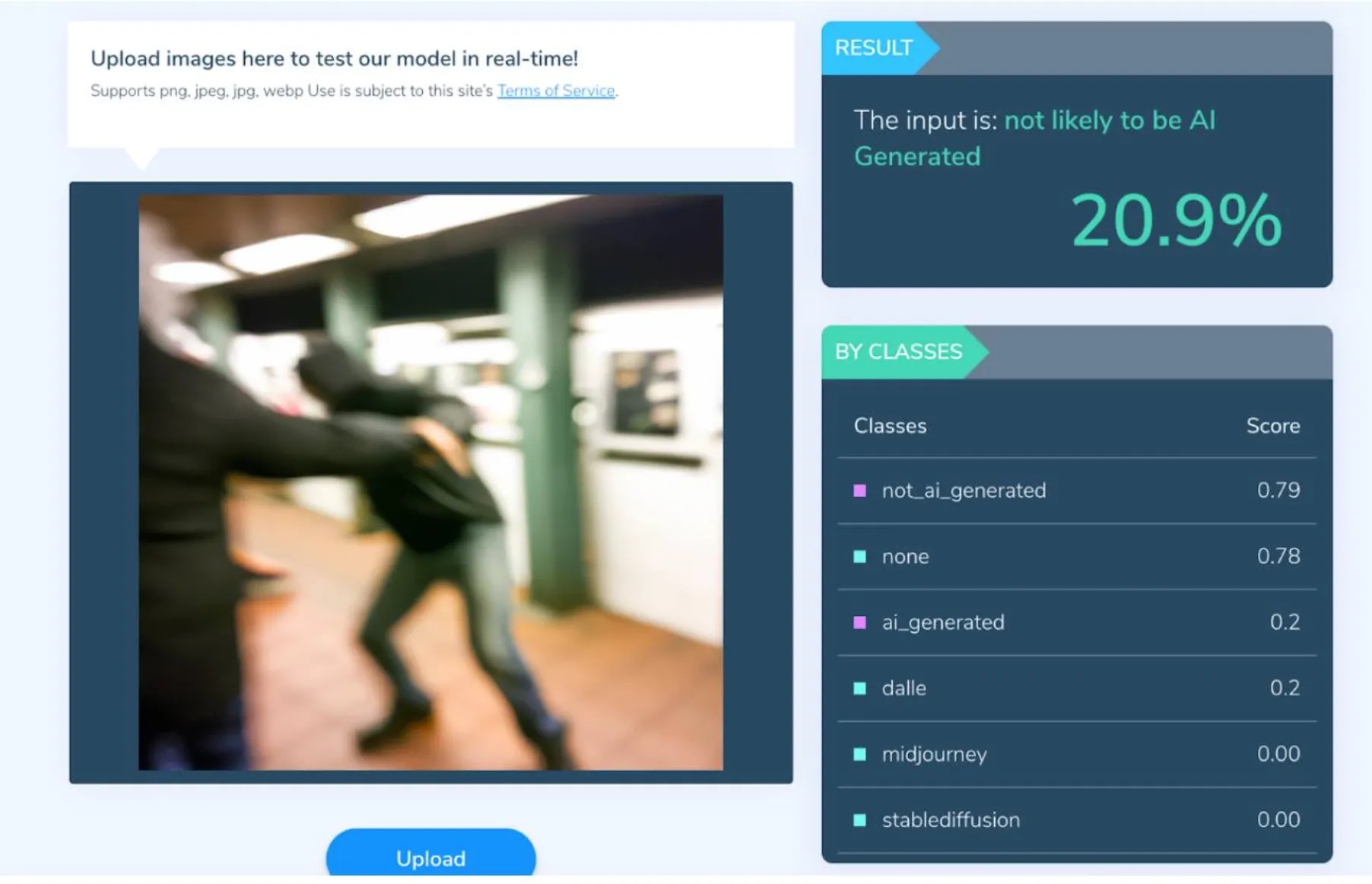

Təsbit vasitələrini qarışdırmaq üçün işdə istifadə edilən başqa bir üsul da görünüşlərdə bulanıqlığı artırmaq idi. Real həyatda çəkilmiş fotoşəkillərin hərəkətə görə bulanıq və ya təhrif olma ehtimalı çox yüksəkdir. DALL-E kimi məhsuldar süni intellekt alətlərinə əmrlər verərkən belə xüsusiyyətləri əlavə etmək mümkündür. Əlavə bulanıqlıq effekti olan şəkil, aşkarlama vasitələrini asanlıqla aldada bilər.

Süni intellektin bulanıqlıq effekti ilə yaratdığı görüntünün təhlilində nəticə 20 faizdir.

Fakt yoxlayıcılar nə etməlidirlər?

Süni intellekt tərəfindən yaradılan şəkillərin və mətnin onlayn dezinformasiya probleminə yeni qat əlavə etdiyi dəqiq olsa da, fakt yoxlayıcıların onları aşkar etmək üçün mükəmməl aləti yoxdur. “Teyit”in bu məsələdə hansı metodologiyaya əməl etdiyinə baxaq.

Redaktor Əli Osman Arabacı deyir ki, fakt yoxlayıcılar ilk növbədə vizual olaraq ayırd edilə bilən ipuçlarına diqqət yetirirlər: “Fakt yoxlayıcılar oxşar iddialardakı dəlilləri və ya ipuçlarını qiymətləndirərkən müəyyən şeylərə baxırlar. Əllərdəki təhriflər, əlavə barmaqlar, qeyri-müəyyən üzlər... Başqa sözlə, biz obyektin təbiətinə uyğun gəlməyən amillərə diqqət yetiririk. Bunlar bəzən məhdudlaşdırıla bilər". (istinad)

Arabacının sözlərinə görə, süni intellekt aşkarlama vasitələrinin mövcud versiyaları məhdud və ziddiyyətli nəticələr təqdim edir:

“Biz süni intellektin yaratdığı şəkilləri fərqləndirən rəqəmsal alətlərin qapısı üzərində işləyirik. Bununla belə, bütün bu məqalənin xülasəsində olduğu kimi, alətlər ziddiyyətli nəticələr verə bilər. Hətta bu alətlərə eyni təsvirin müxtəlif ölçülərini yükləmək və eyni təsvirdən fərqli məlumatlar əldə etmək mümkündür. Heç kim ziddiyyətli məlumatları sevmir. Buna görə də aviasiya tarixi qəzaya uğrayan təyyarələrlə doludur. Biz də bu “təyyarəni” qəzaya uğratmamalıyıq. Buna görə də biz hazırda rəqəmsal alətlərə ehtiyatla yanaşırıq”.

Redaktor Bəşirə Qorxmaz isə təsbit vasitələrinin nəticələrinin qəti sübut kimi təqdim edilə bilməyəcəyi qənaətindədir: “AI aşkarlama vasitələri də ardıcıl və etibarlı deyil. Bu vasitələr süni intellekt iddiaları üçün aydın dəlillər təqdim etmədiyi üçün əsas mənbə kimi daxil edilmir. Hələ insan gözünə görünməyən detalları ortaya qoyan alətlə qarşılaşmamışıq.

Hər mövzuda olduğu kimi süni intellektlə hazırlanan görüntülərdə də birinci mənbə önəmlidir. Bu görüntüləri istehsal edənlər adətən onları süni intellektlə istehsal etdiklərini ifadə edə və ya məlumat verə bilərlər. Bu obrazların yanlış kontekstlərdə yayılması, adətən reallıqla təxəyyülü ayırd edə bilməməkdən irəli gəlir.

Digər tərəfdən, texnologiyanın yaratdığı mürəkkəb dünyaya baxmayaraq, bu şəkillərdəki uyğunsuzluqları aşkar etmək üçün həmişə tənqidi bir gözə ehtiyacımız var. İlk addım obrazın özünün reallığını və onun təqdim olunduğu konteksti şübhə altına almaqdır”.

Xülasə, fakt yoxlayıcıların ən çox istifadə etdiyi üsul şübhəli hesab edilən şəkillərin orijinal versiyasına və ya istehsalçısına müraciət etməkdir. Məzmunun süni intellekt tərəfindən istehsal olunduğunu açıq şəkildə bəyan edən cümlələr və ya etiketlər hazırda fakt yoxlayıcılar tərəfindən süni intellektin aşkarlama vasitələrindən daha etibarlı tapıntı kimi qəbul edilir.