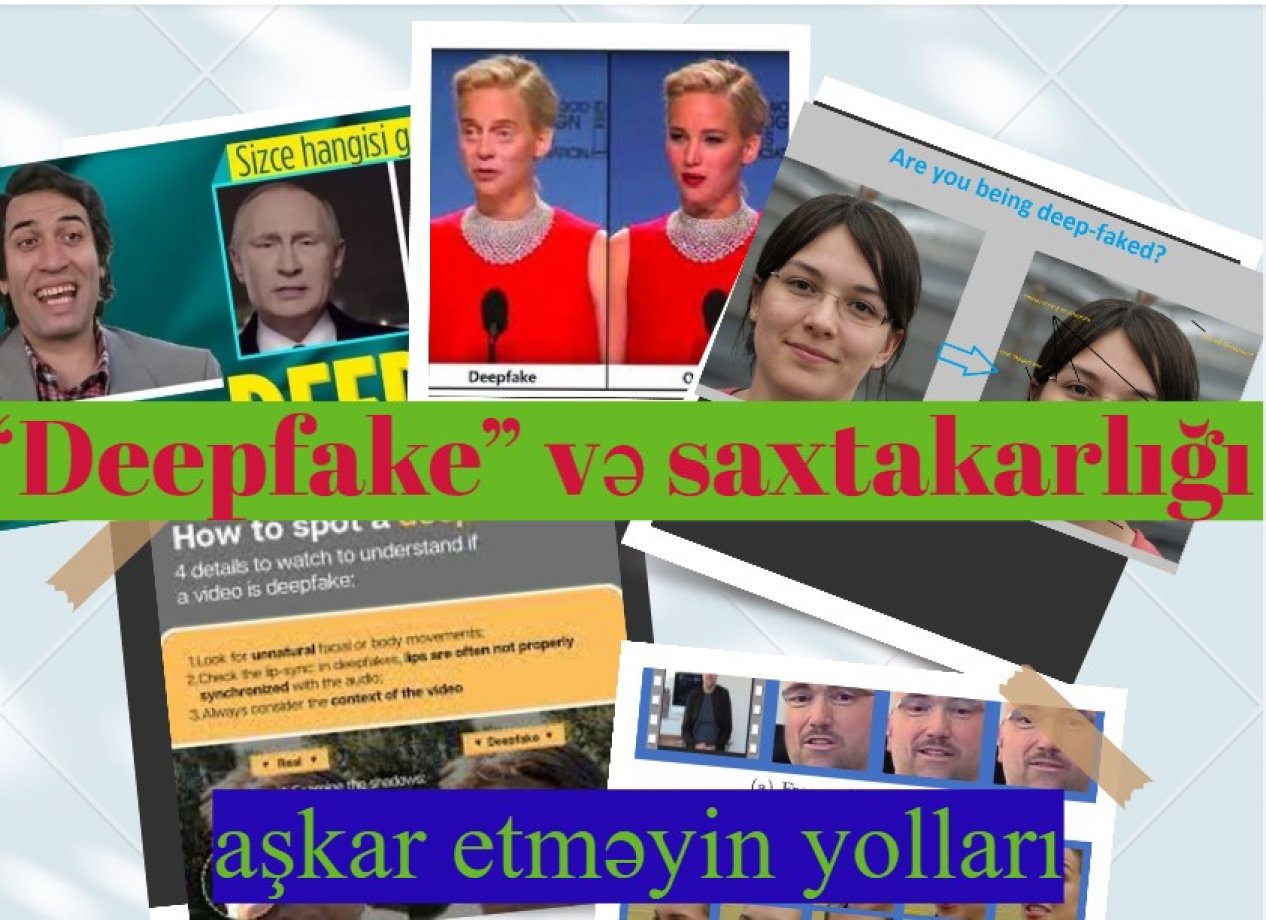

İngilis dilində “dərin öyrənmə” və “saxta” sözlərinin birləşməsindən ibarət olan “deepfake” insanların üzlərini, hərəkətlərini və səslərini real şəkildə təqlid etmək və ya dəyişdirmək üçün süni intellekt texnikalarından istifadə edilməklə yaradılmış fotoşəkilləri, videoları və ya səsləri təsvir etmək üçün istifadə olunur.

Faktyoxla Lab. teyit-ə istinadən “deepfake” nümunələrinin aşkar olunmasının bəzi yollarını təqdim edir.

“Deepfake” əsasən “Generative Adversarial Network” (GAN) adlı texnologiyaya əsaslanır. GAN təsviri tanımaq üçün bir sıra alqoritmlərdən istifadə edir. Bu təlim ona real xüsusiyyətləri öyrənməyə kömək edir ki, saxta şəkillər yarada bilsin.

Üz dəyişdirmə, dodaq sinxronizasiyası, real vaxtda üz hərəkətinin çəkilişi, səs sintezi və filmlərdə və seriallarda gördüyümüz vizual performanslar, qarşılaşa biləcəyiniz “deepfake” nümunələridir.

Əvvəlcə TikTok-da, sonra isə bütün internetdə yayılan “deepfake” “Tom Cruise” videolarının yaradıcısı Kris Ume, yayımladığı videolarla istifadəçilərə belə məzmun istehsalının birdən-birə baş vermədiyi mesajını çatdırmaq istədiyini bildirib.

Tom Kruza oxşayan Miles Fişer (solda) və Kris Ume tərəfindən yaradılmış “deepfake” Tom Cruz (sağda).

Vizual və ya audio məzmunun qabaqcıl üsullarla manipulyasiyasına əsaslanan “deepfake” termini bütün oxşar manipulyasiyaları əhatə etmək üçün kifayət deyil. Bu manipulyasiyaları bir spektr kimi düşündüyümüzdə, digər tərəfdə olan və xatırlanması lazım olan başqa bir növ var: “cheapfake”.

“Cheapfake” nədir?

Məşhur “deepfake” məzmunu ilə müqayisədə ucuz saxtakarlıqlar daha asan və əlçatan alətlərlə yaradılır. “Deeapfake” terminindən sonra ucuz və saxta sözlərinin birləşməsindən əmələ gələn “cheapfake” əvəzinə “shallowfake” (dayazlıq ) və ya “dumbfake” ( axmaqlıq ) terminləri də işlənə bilər.

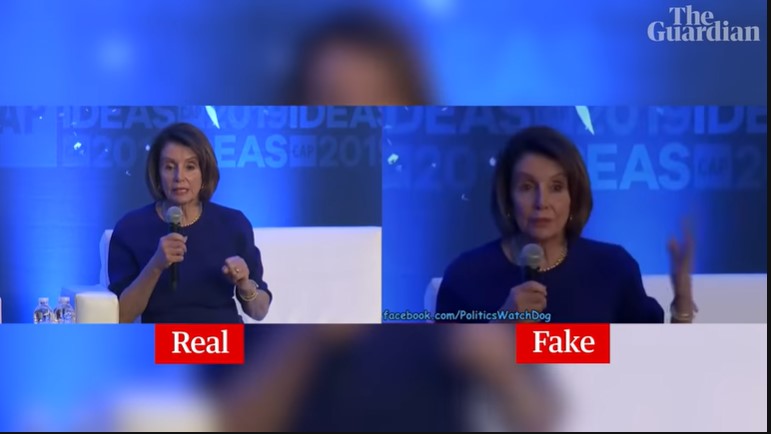

Heç bir proqram istifadə etmədən istehsal edilən ucuz saxta nümunələrə də rast gəlmək mümkündür. Ucuz məzmun müxtəlif üsullarla, məsələn, mövcud görüntüləri kəsərək və ya birləşdirərək kontekstdən çıxarmaq və ya video məzmunun sürətini dəyişdirməklə, adətən “Photoshop” kimi kompüter proqramlarının köməyi ilə hazırlanır.

Bununla belə, ucuz saxtakarlıqlar da sürətlə virallaşa və mübahisə yarada bilər. Xüsusilə dezinformasiya ilə mübarizə haqqında düşünərkən yadda saxlamaq lazımdır ki, dezinformasiyanın yayılması üçün məzmunun həmişə peşəkarlar tərəfindən hazırlanması, yüksək inandırıcı və demək olar ki, fərqlənməyəcək dərəcədə real olması lazım deyil. Məsələn, ABŞ Konqresinin Nümayəndələr Palatasının spikeri Nensi Pelosinin sərxoş olduğunu iddia edən görüntülər, Pelosinin görüntülərini yavaşlatmaqla hazırlanmış çox “inandırıcı” ucuz saxtakarlıq nümunəsidir.

Manipulyasiya dezinformasiyanın yeddi növündən biridir. “deepfake” və ucuz saxta məzmunlar bu kateqoriyada qiymətləndirilə bilən və reklam, zarafat, trollama, nüfuzdan salma, maliyyə və ya siyasi üstünlük əldə etmək kimi müxtəlif məqsədlər üçün edilə bilən müdaxilələrdir.

(Aktyor Kamal Sunalın çəkildiyi reklam çarxı "deepfake" texnologiyası ilə hazırlanan aktual nümunələrdən biridir).

Bu cür məzmunun fərdlər və qurumlar üçün yaratdığı risklər və indiyədək vurduğu ziyan göz qabağındadır. Bu sahədə çalışanlar həll yolunun əməkdaşlıqda olduğunu bildirirlər.

Müxtəlif platformalar istifadəçiləri dərin saxta məzmundan qorumaq üçün addımlar atır. Yüksək qarşılıqlı əlaqə ilə məzmunun sürətlə yayıldığı platformalar bununla bağlı müxtəlif variantlara baş vururlar. Məsələn,”Facebook” və “X” (keçmiş “Twitter”) platformalarında yayılan “deepfake” məzmuna qarşı mübarizə aparılacağı bildirilib.

Bundan əlavə, ABŞ və Çin kimi ölkələr dərin saxta məzmunun yayılmasının qarşısını almaq üçün müxtəlif hüquqi tənzimləmələr tətbiq ediblər.

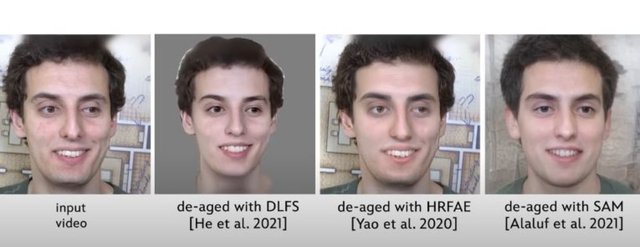

Mütəxəssislər bildirirlər ki, “deepfake” texnologiyasının yaratdığı informasiya pozğunluğu ilə mübarizənin həlli yenə də süni intellekt texnologiyalarından keçir. Texnologiya şirkətləri dərin saxta məzmunu qeyd edəcək aşkarlama sistemlərini inkişaf etdirir, “Deepfake Detection Challenge” ( DFDC ) kimi təşkilatlar da əməkdaşlıq yolu ilə innovasiyaları təşviq etməklə dərin saxtakarlıqları aşkar etmək üçün həllər yaradır.

Bundan əlavə, istifadəçilərin “deepfake” məzmununun mövcudluğu, yayılması və riskləri barədə məlumatlı olması da çox vacibdir. Bələdçidə qeyd etmək istədiyimiz məqam budur. Bütün digər inkişaflarla yanaşı, bu məzmunlarla dezinformasiyanın yayılmasının qarşısını almaq üçün “deepfake” və “cheapfake” məzmunu, onların arxasında duran niyyəti ayırd edə bilmək lazımdır.

Belə məzmunu necə aşkarlaya bilərik?

Bunu aşkar etmək üçün nəzərə alınmalı bir çox məqam var.

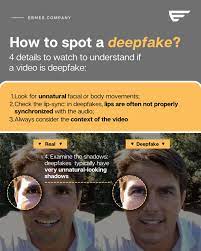

Gözlər: Videodakı şəxsin qeyri-təbii göz hərəkətləri varsa və ya heç qırpmırsa, bu, “deepfake” üçün bir ipucu ola bilər. 2018-ci ildə tədqiqatçılar aşkar etdilər ki, “deepfake” məzmun yanıb-sönən hərəkəti təbii görünən şəkildə təkrarlaya bilməz. Həmin zərfdə göz qırpmaq imkanı verən dərin saxta məzmunun hazırlanmasında müəyyən irəliləyiş əldə olunsa da, buna diqqət yetirmək hələ də faydalıdır.

Üz: “Deepfake” texnologiyası ilə hazırlanan məzmunda dəri hamar və ya çox qırışmış görünə bilər və ya üzdəki xal real görünə bilməz.

Eynək: Parıltı varmı? İnsan hərəkət edərkən parıltı bucağı dəyişirmi? “Deepfake” məzmunu işıqlandırmanın və əksin təbii fizikasını böyük dəqiqliklə əks etdirə bilməz.

Qeyri-təbii üz ifadələri: Üz haqqında təfərrüatların dəqiq və təbii görünmədiyi vəziyyətlər üz dəyişdirmə texnikasını göstərə bilər. Şəkildəki şəxsin üzü danışığı ilə uyğunlaşmalı olan emosiyanı göstərmirsə, bu, əlavələr və dəyişiklikləri görməyə kömək edə bilər.

Qəribə görünüşlü bədən və ya duruş: Vacib ipuçlarına insanın bədən formasının qeyri-təbii görünüşü və ya baş və bədənin yöndəmsiz və ya uyğun olmayan yerləşməsi daxildir. “Deepfake” texnologiyası çox vaxt bütün bədənə deyil, üzə fokuslandığı üçün bu, aşkarlanması asan uyğunsuzluqlardan biri ola bilər.

Qeyri-təbii bədən hərəkəti: Bir insan başını çevirən və ya hərəkət etdirən zaman bir kadr digərinə nisbətən bağlantısızdırsa, şübhələnməyə əsasınız var.

Qeyri-təbii rəngləmə: Anormal dəri tonu, rəngsizləşmə, qəribə işıqlandırma, göz və qaş ətrafında yersiz kölgələr gördüyünüz şeyin saxta olduğunu göstərən əlamətlər ola bilər.

Saç: “Deepfake” ilə yaradılan məzmundakı saçlar çox vaxt donuq olur və tüklər bir-birinə uyğun gəlmir. Saçların ağarması, üzdə və gözlərdə qocalma əlaməti, qırışlar bir-biri ilə uyğun gəlməyə bilər. Eynilə, saqqal da kifayət qədər real görünməyə bilər.

Qeyri-təbii dişlər: Alqoritmlər fərdi dişlər üzərində işləyə bilməyə bilər, buna görə də bütün fərdi dişlərin konturlarının olmaması bir ipucu ola bilər.

Bulanıqlıq və ya yanlış yönləndirmə: Şəkillərin kənarları bulanıq olarsa və ya şəkillərdə yanlış yönlənmə olarsa - məsələn, kiminsə üzü və boynu bədəni ilə üst-üstə düşməzsə, siz nəyinsə səhv ola biləcəyini düşünə bilərsiniz.

Uyğun olmayan səs-küy və ya audio: Zəif dodaq sinxronizasiyası, robot səslər, qəribə söz tələffüzləri, fon səs-küyü və ya hətta səsin olmaması saxta məzmunu ayırd etmək üçün istifadə edilə bilər.

Yavaşladıqda qeyri-təbii şəkillər: Smartfonunuzun ekranından daha böyük ekranda videoya baxırsınızsa və ya normal oxuma sürətindən daha yavaş videoya baxırsınızsa, yaxınlaşdırıb şəkilləri yoxlaya bilərsiniz. Məsələn, bir insanın dodaqlarına yaxından baxmaq, onun həqiqətən danışıb-danışmadığını və ya dodaq sinxronizasiyasının zəif olub-olmadığını görməyə kömək edə bilər.

Tərsinə şəkil axtarışı: Oxşar videoların onlayn axtarışı foto və ya videonun hər hansı şəkildə dəyişdirilib-dəyişdirilmədiyini müəyyən etməyə kömək etmək üçün istifadə edilə bilər. Əks video axtarış texnologiyası hələ çox inkişaf etməsə də, əks görüntü axtarışı videodan kadr seçməklə həyata keçirilə bilər.

Rəqəmsal barmaq izləri: Qüsursuz olmasa da, blokçeyn əsaslı yoxlama sistemi videonun həqiqiliyini müəyyən etməyə kömək edə bilər. Sadəcə olaraq, video yaradıldıqda məzmun dəyişdirilə bilməyən və videonun həqiqiliyini sübut etməyə kömək edə bilən yaddaşda saxlanılır.

Alətlər mövcuddur

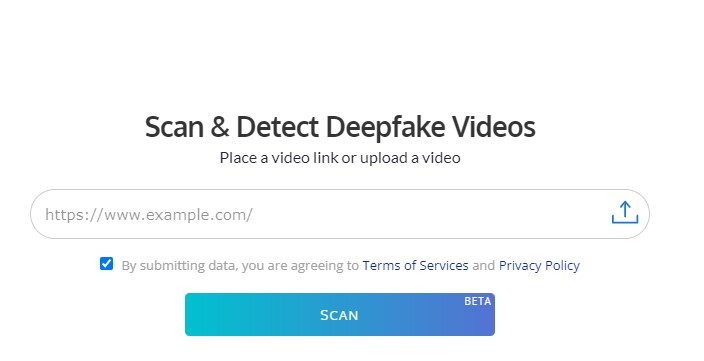

Müxtəlif komandalar inkişaf etdirdikləri proqram təminatı ilə süni intellektin şəffaflığını təmin etmək və istifadəçiləri dərin saxtakarlığa qarşı maarifləndirmək yollarını şaxələndirirlər. “Sensity AI”, “DeepFake-o-meter”, “Deepware AI” kimi vasitələrdən istifadə edərək şübhələndiyiniz videonu yoxlamağa cəhd edə bilərsiniz.

Məzmunun “deepfake” olub-olmadığını müəyyən etmək üçün istifadə edilən alqoritmlərin yaradıcıları öz yeni texnologiyaları ilə ən son “deepfake”lərin qarşısını alarkən, “deepfake” texnologiyası da öyrənməyə və inkişaf etməyə davam edir. Şübhəli məzmunu araşdırarkən nəzərə alınmalı olan məqamlar da zamanla dəyişir.

Bu münaqişə davam edərkən, məzmunun arxasındakı texnologiyanın necə işlədiyini başa düşmək və aşkarlanması üçün istifadə edilə bilən ipuçlarını təmin edən detallara diqqət yetirmək dərin saxta məzmuna qarşı şübhəni gücləndirməyin ən təsirli yoludur.